Introducción al Workflow

AI agent chat | n8n workflow template

Propósito del Workflow:

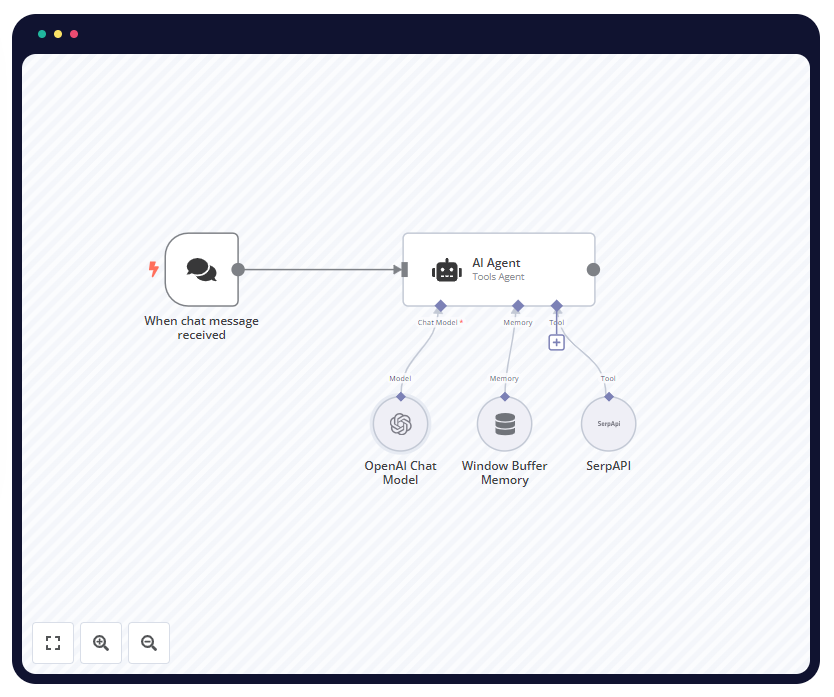

Este workflow de n8n está diseñado para actuar como un agente de inteligencia artificial (AI) que interactúa en un chat. Utiliza el modelo de lenguaje de OpenAI para procesar y generar respuestas basadas en las entradas de los usuarios. Además, el workflow incluye memoria temporal (window buffer memory) para recordar el contexto de la conversación y una integración con SerpAPI, lo que permite al agente realizar búsquedas en la web y utilizar esa información para responder de manera más precisa y contextualizada.

Contexto de uso:

Este workflow es especialmente útil en escenarios donde se requiere un agente conversacional capaz de mantener contexto y realizar búsquedas en la web para mejorar la calidad de sus respuestas. Puede ser implementado en sistemas de atención al cliente, chatbots en sitios web o aplicaciones de mensajería, donde se necesite asistencia automatizada con capacidad para acceder a información actualizada y relevante de internet. Además, la flexibilidad de n8n permite que este workflow se integre fácilmente con otros sistemas y servicios, ampliando así su utilidad en diferentes entornos.

Análisis de los Nodos

- When chat message received (Nodo de disparo de chat):

- Función: Este nodo se activa cuando se recibe un nuevo mensaje en el chat. Es el punto de entrada del workflow, capturando el input del usuario para procesarlo.

- Configuración: No tiene parámetros adicionales configurados. Simplemente espera un mensaje para activar el flujo.

- Interacción: Inicia el workflow y pasa el mensaje recibido al siguiente nodo, que en este caso es el «AI Agent».

- AI Agent (Agente AI):

- Función: Este nodo es el núcleo del workflow, actuando como un agente que utiliza un modelo de lenguaje (OpenAI) y otras herramientas (SerpAPI, memoria) para generar una respuesta al mensaje recibido.

- Configuración: Configurado para operar con varias opciones, incluyendo la integración con modelos de lenguaje, memoria de contexto, y herramientas externas como SerpAPI.

- Interacción: Recibe el input desde el nodo de chat y consulta los otros nodos (como el modelo de lenguaje y la memoria) para formular una respuesta adecuada.

- OpenAI Chat Model:

- Función: Este nodo utiliza el modelo de lenguaje GPT-4o-mini de OpenAI para generar texto basado en la entrada del usuario. Es crucial para crear respuestas coherentes y contextuales.

- Configuración: Está configurado para utilizar el modelo «gpt-4o-mini». No se han especificado opciones adicionales.

- Interacción: Se conecta con el nodo «AI Agent» como su modelo de lenguaje, proporcionando las capacidades necesarias para procesar y generar respuestas.

- Window Buffer Memory (Memoria Buffer de Ventana):

- Función: Este nodo almacena un buffer de mensajes anteriores en la conversación para mantener el contexto. Es útil para que el agente AI recuerde la conversación previa y genere respuestas más contextuales.

- Configuración: Sin configuraciones adicionales; su función principal es almacenar y recuperar el contexto de la conversación.

- Interacción: Está conectado al nodo «AI Agent», proporcionándole acceso al historial de la conversación para mejorar la coherencia de las respuestas.

- SerpAPI:

- Función: Este nodo permite al agente realizar búsquedas en la web a través de SerpAPI, lo que es especialmente útil para obtener información actualizada y relevante para las respuestas.

- Configuración: Se conecta con una cuenta SerpAPI configurada y no tiene opciones adicionales especificadas.

- Interacción: Proporciona datos al nodo «AI Agent», permitiendo que el agente consulte información en tiempo real y la utilice en sus respuestas.

Explicación del Flujo

- El flujo comienza cuando se recibe un mensaje de chat a través del nodo «When chat message received».

- Este mensaje se pasa al «AI Agent», que actúa como el controlador central del flujo.

- El «AI Agent» consulta al nodo «OpenAI Chat Model» para procesar el mensaje y generar una respuesta preliminar basada en su modelo de lenguaje.

- Si es necesario, el «AI Agent» también consulta el nodo «Window Buffer Memory» para recordar el contexto de la conversación anterior, asegurando que la respuesta sea coherente con la interacción previa.

- Además, si la pregunta del usuario requiere información externa, el «AI Agent» puede utilizar el nodo «SerpAPI» para realizar una búsqueda en la web y obtener datos actualizados.

- Finalmente, el «AI Agent» combina todas estas fuentes de información para generar y devolver una respuesta completa al usuario a través del chat.

Este flujo garantiza que el agente AI no solo sea capaz de entender y generar texto coherente, sino que también pueda mantener el contexto y acceder a información externa en tiempo real, lo que lo convierte en una herramienta poderosa para interacciones automatizadas.

JSON del Workflow

El siguiente es el JSON correspondiente al workflow que estamos analizando. A continuación, desglosaré los componentes más relevantes y cómo afectan el funcionamiento del workflow.

{

"meta": {

"instanceId": "408f9fb9940c3cb18ffdef0e0150fe342d6e655c3a9fac21f0f644e8bedabcd9"

},

"nodes": [

{

"id": "939bb301-5e12-4d5b-9a56-61a61cca5f0d",

"name": "OpenAI Chat Model",

"type": "@n8n/n8n-nodes-langchain.lmChatOpenAi",

"position": [

640,

460

],

"parameters": {

"model": "gpt-4o-mini",

"options": {}

},

"credentials": {

"openAiApi": {

"id": "8gccIjcuf3gvaoEr",

"name": "OpenAi account"

}

},

"typeVersion": 1

},

{

"id": "372777e8-ce90-4dea-befc-ac1b2eb4729f",

"name": "Window Buffer Memory",

"type": "@n8n/n8n-nodes-langchain.memoryBufferWindow",

"position": [

780,

460

],

"parameters": {},

"typeVersion": 1.2

},

{

"id": "7a8f0ad1-1c00-4043-b3e5-c88521140a1a",

"name": "SerpAPI",

"type": "@n8n/n8n-nodes-langchain.toolSerpApi",

"position": [

920,

460

],

"parameters": {

"options": {}

},

"credentials": {

"serpApi": {

"id": "aJCKjxx6U3K7ydDe",

"name": "SerpAPI account"

}

},

"typeVersion": 1

},

{

"id": "a7624108-e3da-4193-a625-887314216b8b",

"name": "When chat message received",

"type": "@n8n/n8n-nodes-langchain.chatTrigger",

"position": [

360,

240

],

"webhookId": "53c136fe-3e77-4709-a143-fe82746dd8b6",

"parameters": {

"options": {}

},

"typeVersion": 1.1

},

{

"id": "6b8b7de8-fe3f-43b5-97ce-a52a9e44eb5e",

"name": "AI Agent",

"type": "@n8n/n8n-nodes-langchain.agent",

"position": [

680,

240

],

"parameters": {

"options": {}

},

"typeVersion": 1.6

}

],

"pinData": {},

"connections": {

"SerpAPI": {

"ai_tool": [

[

{

"node": "AI Agent",

"type": "ai_tool",

"index": 0

}

]

]

},

"OpenAI Chat Model": {

"ai_languageModel": [

[

{

"node": "AI Agent",

"type": "ai_languageModel",

"index": 0

}

]

]

},

"Window Buffer Memory": {

"ai_memory": [

[

{

"node": "AI Agent",

"type": "ai_memory",

"index": 0

}

]

]

},

"When chat message received": {

"main": [

[

{

"node": "AI Agent",

"type": "main",

"index": 0

}

]

]

}

}

}Estructura del JSON:

meta: Contiene información meta sobre la instancia de n8n.nodes: Lista de nodos utilizados en el workflow. Cada nodo tiene unid,name,type,position,parameters,credentials, ytypeVersion.connections: Define cómo los nodos están conectados entre sí. Cada nodo puede tener múltiples conexiones de salida que dictan cómo fluye la información a través del workflow.

Componentes Específicos:

- Modelo de lenguaje OpenAI (

OpenAI Chat Model): Especificado comogpt-4o-mini, este nodo es responsable de la generación de texto. Está asociado con una cuenta de OpenAI a través de las credenciales. - Memoria (

Window Buffer Memory): Aunque no tiene parámetros adicionales, su función es esencial para la coherencia en la conversación, almacenando y proporcionando contexto histórico. - Herramienta de búsqueda (

SerpAPI): Este nodo permite la consulta en tiempo real a través de una API de búsqueda, mejorando las capacidades del agente para obtener datos relevantes y actuales. - Agente AI (

AI Agent): Este nodo centraliza la interacción con el modelo de lenguaje, la memoria y la herramienta de búsqueda, integrando todos estos elementos para responder de manera efectiva al input del usuario.

Código Personalizado

En este workflow en particular, no hay nodos que incluyan código personalizado directamente en el JSON. Sin embargo, los nodos y sus configuraciones, como los parámetros del modelo de lenguaje o las credenciales de SerpAPI, son esenciales para el funcionamiento del workflow.

Si se necesitara añadir lógica personalizada o modificar cómo se procesan las respuestas, esto podría hacerse a través de nodos adicionales que ejecuten código (como el nodo Function en n8n), aunque no están presentes en este caso específico.

Posibles Mejoras y Adaptaciones

Optimización

- Optimización del Modelo de Lenguaje:

- Uso de modelos específicos para tareas particulares: Dependiendo del tipo de consultas que se espera que maneje el agente, podría ser útil configurar el modelo de lenguaje con parámetros más específicos o utilizar un modelo diferente si el enfoque es la velocidad o la especialización en ciertas tareas. Por ejemplo, si el agente principalmente responde preguntas frecuentes, podría usarse un modelo más pequeño y rápido que se ajuste mejor a ese propósito.

- Filtrado de información previa a la consulta del modelo: Antes de enviar la consulta al modelo de lenguaje, se podría incluir un nodo que filtre o preprocese el input del usuario para reducir ruido y mejorar la precisión de la respuesta generada.

- Memoria de Contexto:

- Ajuste del tamaño de la ventana de memoria: La memoria de contexto puede ser ajustada para almacenar un mayor o menor número de interacciones anteriores, según sea necesario. Esto permitiría un mayor control sobre la cantidad de información que el agente utiliza para generar respuestas, optimizando el uso de recursos y la relevancia del contexto.

- Condiciones de reset de la memoria: Implementar un nodo que resetee la memoria después de un cierto período de inactividad o cuando se detecta un cambio de tema en la conversación, para evitar que el contexto acumulado se vuelva irrelevante o confuso.

- Consulta en la Web con SerpAPI:

- Limitación de consultas innecesarias: Se podría introducir un nodo de decisión que determine si realmente es necesario realizar una búsqueda en la web antes de enviar la consulta a SerpAPI, optimizando el uso de la API y reduciendo el tiempo de respuesta.

- Caché de resultados: Implementar un sistema de caché para almacenar los resultados de búsquedas frecuentes, reduciendo la cantidad de consultas repetidas y mejorando la velocidad de respuesta del agente.

Escalabilidad

- Manejo de Conversaciones Simultáneas:

- Instancias paralelas del workflow: Para manejar múltiples conversaciones simultáneas, se podrían crear instancias paralelas del workflow, cada una gestionando su propio hilo de conversación, asegurando así que el agente pueda interactuar con varios usuarios al mismo tiempo sin pérdida de rendimiento.

- Integración con Sistemas Externos:

- Ampliación del workflow: Este workflow podría integrarse con otros sistemas empresariales, como CRMs o bases de datos internas, para proporcionar respuestas más personalizadas o realizar acciones automatizadas basadas en las consultas del usuario. Esto se podría lograr añadiendo nodos adicionales que conecten con estos sistemas.

- Distribución en la nube: Considerar la implementación de este workflow en un entorno cloud escalable (como AWS Lambda o Google Cloud Functions) para manejar picos de demanda sin comprometer el rendimiento.

Variantes del Workflow

- Chatbot de Atención al Cliente:

- Este workflow podría ser adaptado para funcionar como un chatbot de atención al cliente que no solo responde preguntas frecuentes, sino que también maneja tareas específicas como la creación de tickets de soporte o la consulta de estados de pedidos, integrándose con APIs de sistemas de gestión.

- Asistente de Investigación:

- En un entorno académico o de investigación, el workflow podría ser adaptado para ayudar en la recopilación de información sobre temas específicos, utilizando el nodo SerpAPI para realizar búsquedas detalladas y el nodo de memoria para mantener el contexto sobre un proyecto en particular.

- Asistente de Redes Sociales:

- Se podría crear una variante de este workflow que actúe como un asistente para la gestión de redes sociales, utilizando SerpAPI para monitorizar menciones o tendencias, y el modelo de lenguaje para generar respuestas o publicaciones basadas en esas consultas.

Conclusiones y Aplicaciones Prácticas

Este workflow de n8n ofrece una solución poderosa y flexible para la implementación de un agente conversacional basado en inteligencia artificial. Al combinar un modelo de lenguaje avanzado con memoria contextual y capacidades de búsqueda en tiempo real, proporciona una experiencia de usuario mucho más rica y adaptada a las necesidades actuales.

Las aplicaciones prácticas de este workflow son vastas y variadas. Puede ser utilizado en entornos de atención al cliente, donde la capacidad de mantener el contexto y acceder a información actualizada es crucial para ofrecer respuestas precisas y útiles. Además, su capacidad para integrarse con otros sistemas y manejar múltiples interacciones simultáneamente lo hace ideal para su despliegue en empresas que buscan automatizar y optimizar la interacción con sus clientes.

Más allá del ámbito empresarial, este workflow también puede ser adaptado para uso en educación, investigación o incluso en la gestión de redes sociales, destacando su versatilidad y potencial para ser personalizado según las necesidades específicas de cada usuario o sector.

Te invito a probar este workflow en tu entorno específico, experimentando con las configuraciones y adaptaciones sugeridas para maximizar su utilidad. Si estás buscando automatizar interacciones o mejorar la eficiencia de tus procesos de comunicación, este workflow de n8n es una excelente base desde la cual construir. ¡No dudes en compartir tus experiencias o en pedir asistencia adicional para adaptarlo a tus necesidades particulares!

Deja un comentario